拡散モデルを VAE, GAN に並ぶ有力な手法に押し上げた決定的な論文. 結局, 拡散モデルをどのように実装すればうまくいくのかという話だが, 拡散モデルと Langevin 動力学を用いたデノイジングスコアマッチングの関連を見抜き, それに基づいてデザインされた手法を提示した点は革新的といえる.

- 生成分布

- 逆拡散過程

- 拡散過程

- 訓練 (負の対数尤度に対する変分上限 の最小化)

拡散モデルとデノイジングオートエンコーダー (DAE)

拡散過程と

, , スケジュール の選び方.

本来, 拡散率 は学習可能な変数であるが, 今回はこれを定数とする. すると, が学習可能な量を持たなくなるので, も訓練において定数となり無視できる.

逆拡散過程と

, , , および の選び方.

分散

と, 時間に依存する定数にとる.

ここにおいて以下 2 つの極端な選び方が存在するが, 同様の結果が得られるようで, 結局のところ選べる値であれば何でもいいらしい.

-

と拡散過程の分散にとる.

のとき最適, Sohl-dickstein et al. (2015) で評価された逆拡散過程のエントロピーが上限を取る場合に対応.

-

と事後分布の分散にとる.

が確定した 1 点のとき最適, Sohl-dickstein et al. (2015) で評価された逆拡散過程のエントロピーが下限を取る場合に対応.

平均

をノイズ を用いて と再パラメータ化することにより, を次のように選ぶことができる.

この着想は, 拡散モデルにおける訓練が (ノイズとスコアを同一視すれば) によって添字付けられた複数ノイズスケールでのデノイジングスコアマッチング (DSM) と等価になる, という次の洞察による.

したがってこのとき, Langevin 動力学を用いたサンプリングは次で与えられる.

データスケーリングと逆拡散過程デコーダー, および

画像データの要素 を と線形にスケーリングし, 標準正規事前分布 から始まる逆拡散過程が一貫性をもって作用できることを保証しておく. そうすると, 最終ステップ () では特別に, 連続 Gauss 分布から離散画像データの確率分布に変換する次の独立デコーダーが必要となる.

, および の簡略化

から重み を捨て, ステップを と一様サンプリングすれば, を含めた変分上限は次のように簡略化される.

では と一致. ではこれにより, ステップ初期のノイズが小さい場合の重みがステップ後半におけるノイズが大きい場合と比べて相対的に小さくなるため, モデルはノイズが大きい場合の難しいタスクにより多くのリソースを割けるようになり, 結果としてサンプルの品質も向上すると主張されている.

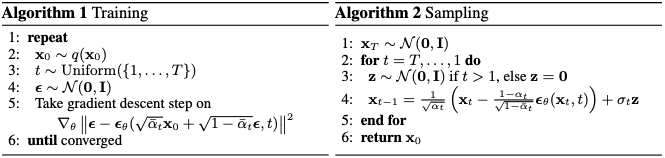

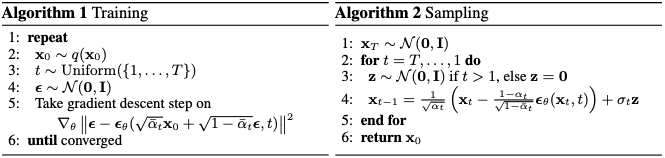

まとめると, 最終的に提示されたアルゴリズムは以下である.