スコアを予測しそれを用いてサンプリングを行うスコアベース手法の提示. 構成要素は次の 2 つ.

- デノイジングスコアマッチング (DSM) によるスコア推定

- 焼きなまし Langevin 動力学を用いたサンプリング

各々, ナイーブなスコアマッチング, および ナイーブな Langevin MCMC が抱える以下の課題を克服する発想となっている.

- 多様体仮説のもとでの課題

- データが低次元多様体に押し込められているとき, その周囲の高次元多様体での勾配は定義できないから, スコアも定義不能となる.

- データ分布の台が高次元多様体にまで広がっていなければ, 目的関数によるスコア推定は一貫性を失う.

- データの低密度領域が存在することによる課題

- 目的関数により推定されたスコアが正確性を失う.

- 低密度領域によって隔てられた 2 つのモードが存在するとき, それらの相対的な重みを再現する分布に収束しにくい.

記法

- データセット : なサンプル の集合.

- のスコア : の対数尤度に関する勾配.

- スコアネットワーク : スコアを予測するために訓練される によってパラメータ付けされた NN.

スコアマッチングによるスコア推定

最小化されるべき目的関数を素直に書き下せば以下のようになる.

しかしながらここにおいて が未知ゆえそのスコアは計算不能である.

— 目的関数の計算可能な形への書き換え —

を積分の形であらわに書く.

第 1 項は に依存しない定数. 第 2 項は次のように書き直せる.

したがって目的関数を未知のスコアを用いない形式に書き表せた. ただし, 定数部分は省略した.

しかしながら, の計算量は膨大である.

— デノイジングスコアマッチング (DSM) —

そこで, 事前に決められたノイズ分布 により に摂動を加えることで, 目的関数を素直な形のまま計算可能にし, 高価な Jacobian のトレース計算を回避する.

- 摂動後データ分布:

- 目的関数:

ここで のスコアが計算可能となることは具体例をもって明らかとなる. 例えば, 本論文で提示されているノイズ条件付きスコアネットワーク (NCSN) だと, とし .

Langevin 動力学を用いたサンプリング

スコア関数のみを用いてサンプリングできるという著しい特徴を持つ. 固定ステップ長を , 事前分布 のもとで初期値を とすれば, サンプリングは以下で与えられる.

ただし, .

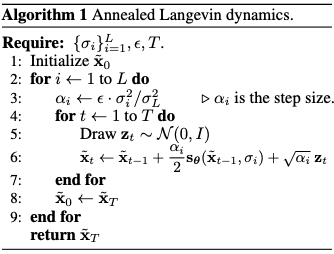

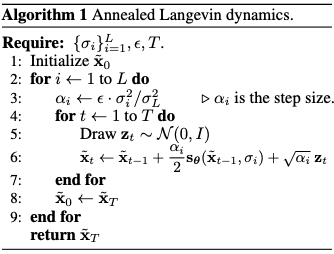

— 焼きなまし Langevin 動力学を用いたサンプリング —

を を満たす正幾何級数として, 以下で与えられる.