言わずと知れた VAE 論文だが, 理論的な骨子は次の2点.

- 真の事後分布の近似として, 認識モデルを導入

- 再パラメータ化を行い, 効率的な推定器を開発

認識モデル の導入

変分下限 (variational lower bound) の最大化に帰着.

— 記法と仮定 —

- データセット , な 個の連続サンプル の集合.

- サンプル は次のプロセスで無作為に生成されると仮定.

- によりパラメータ付けされた事前分布 が連続潜在変数(code) を生成.

- その下での条件付き分布(decoder) が を生成.

- と は で と に関して偏微分可能と仮定.

- 認識モデル(encoder), 真の事後分布 の近似.

- 周辺尤度 .

— の計算 —

— 各項の解釈 —

- : 正則化項, エンコーダが事前分布から離れ過ぎないように圧力をかける. 小さくしたい.

- : 期待される負の再構成誤差, デコーダによる尤度が高ければ誤差は小さい. 大きくしたい.

再パラメータ化トリック

ランダム変数を決定論的変数へ書き換えることで, 変分下限に新たな表現(推定器)を与える.

— トリック —

ランダムサンプリング を連続変数, かつパラメータ に対して微分可能と仮定すると, ある独立周辺分布 によってサンプルされるノイズ変数 , および によってパラメータ付けされたあるベクトル値関数 を用いて, 潜在変数 は次のように再パラメータ化される.

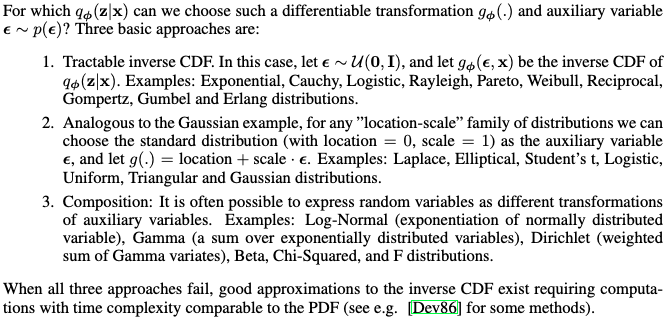

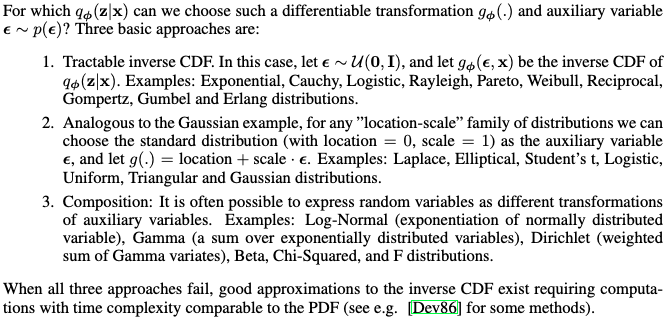

や は以下のように選べばいい.

— 確率勾配変分 Bayes (SGVB) 推定器 —

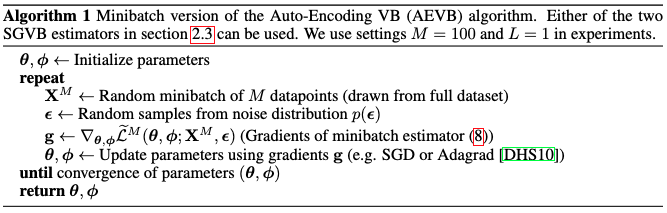

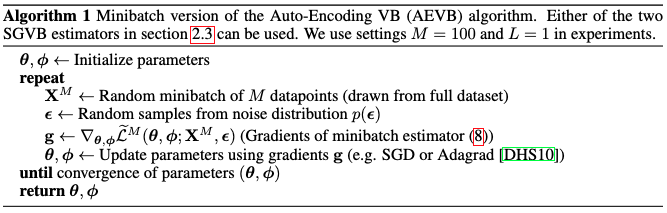

— Auto-Encoding 変分 Bayes (AEVB) アルゴリズム —

最終的なアルゴリズム. データの一部 ( データ点の内 点) により結果を再現する, 次のミニバッチ法も含む.

変分 Auto-Encoder (VAE)

以下のように選んだものを VAE と呼ぶ.

- .

- 多変量 Gauss/Bernoulli 分布. パラメータ は多層パーセプトロン (MLP) により から計算される.

- . 平均 , および標準偏差 (併せてパラメータ ) も MLP により から計算される.

— 推定器の具体的表式 —

ここで, Hadamard 積 として, .